¿Cómo funcionan los LLM?

Breve introducción

¿Alguna vez te has preguntado cómo es posible que una inteligencia artificial pueda escribir, traducir, resumir y hasta crear código como si lo hiciera un humano? La respuesta se esconde en los LLM, una de las tecnologías más revolucionarias de nuestra era.

Aquí, exploraremos qué son, cómo se entrenan y qué los hace tan "inteligentes". Acompáñame a descubrir los mecanismos fundamentales que permiten a estas herramientas entender el lenguaje humano a una escala sin precedentes. Prepárate para una inmersión en la intersección entre la lingüística, la ciencia de datos y la inteligencia artificial.

¿Qué significa tokenizar el lenguaje?

Los LLM, del inglés Large Language Models (modelos de lenguaje grandes), como ChatGPT, Gemini o Claude, son sistemas de predicción estadística que funcionan principalmente con base en complejos cálculos matemáticos.

El primer paso en su proceso es la tokenización del lenguaje. Esto consiste en tomar un texto y dividirlo en unidades más pequeñas llamadas tokens. Estas unidades pueden ser palabras, partes de palabras (sílabas) o incluso caracteres, dependiendo de cómo esté configurado el modelo.

El objetivo de la tokenización es que el LLM pueda procesar y entender el lenguaje humano de una manera estructurada, convirtiendo las palabras en un formato que la máquina pueda interpretar y trabajar con él.

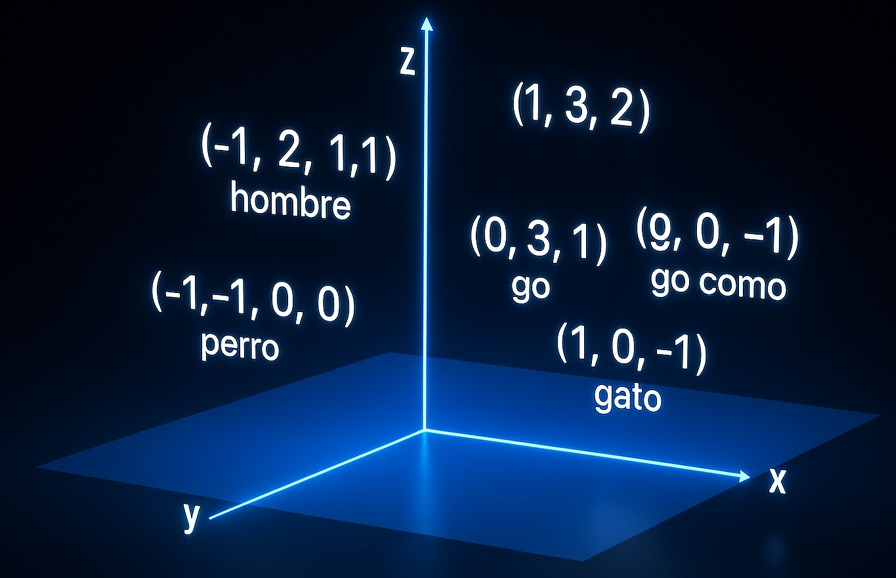

Tres Dimensiones a n-dimensiones

Las palabras deben ser ordenadas como vectores dentro de un espacio tridimensional (con ejes X, Y, Z). Es decir, cada palabra existe en un punto de este espacio, lo que la hace equivalente a un vector que puede ser procesado. Por ejemplo, la palabra "perro" podría tener las coordenadas (7, 4, 8), aunque esto es solo un ejemplo.

Los humanos vivimos en un mundo de tres dimensiones y tenemos la capacidad de entender esto muy bien. Sin embargo, las máquinas pueden comprender 4, 5, 6 o incluso más dimensiones. Esto permite a los sistemas llegar a tener muchas más dimensiones (n-dimensiones), lo cual, junto con la matemática, hace que los Grandes Modelos de Lenguaje (LLMs) sean tan poderosos.

A continuación, hay un video donde un niño lo explica de forma excelente. Existe un mito sobre él, que dice que desapareció después de haber hecho este video. La verdad, no lo sé, pero lo que sí sé es que lo explica muy bien. Además, está en español.

Video de las dimensiones

Recuerda activar la mejor calidad en YouTube, para mejor visualización del video

Echa un vistazo a este video para ver como funcionan las dimensiones

Los embeddings

son una forma de representar palabras, frases o incluso documentos completos como vectores numéricos

en un espacio matemático de muchas dimensiones.

Las computadoras no “entienden” el lenguaje natural directamente. Necesitan convertirlo a números para poder procesarlo.

Los embeddings son esa traducción: convierten un texto en una secuencia de números que capturan su significado y no solo su forma.

Luego de realizar la tokenización, es necesario agrupar las palabras relacionadas. Por ejemplo, los vectores de las palabras "perro" y "can" pueden estar muy próximos entre sí, ya que son palabras que se relacionan directamente. Debido a esta proximidad, sus vectores se sitúan en un espacio vectorial similar.

A esto se le conoce como Los embeddings

(Clic en la imagen para ampliar)

Los vectores, clave matemática para comprender los LLM

Para comprender mejor estos conceptos y los que veremos más adelante, también es importante conocer qué es un vector matemáticamente hablando.

Imagina que estás en una habitación. Para describir la ubicación de cualquier objeto en esa habitación, necesitas tres datos:

- Qué tan lejos está de una pared (el largo, o el eje X).

- Qué tan lejos está de la pared contigua (el ancho, o el eje Y).

- Qué tan alto está del suelo (la altura, o el eje Z).

Un vector tridimensional es simplemente un conjunto de tres números que te dan la posición de un punto en ese espacio, como las coordenadas (X, Y, Z). Es como una flecha que va desde el punto de inicio de la habitación (la esquina del suelo) hasta la ubicación exacta del objeto.

En los LLMs, en lugar de ubicar un objeto físico, se ubican palabras. Cada palabra es un "objeto", y sus coordenadas en ese espacio de tres (o más) dimensiones representan su significado y su relación con otras palabras.

Si eres como yo probablemente entiendes mejor con un video, que con una explicación escrita, así que aquí está:

Explicación matemática de un vector tridimensional

Recuerda activar la mejor calidad en YouTube, para mejor visualización del video, y recuerda, esta es una explicación tridimensional, los LLM pueden usar muchas más dimensiones, si entiendes el uso tridimensional, puedes tener noción de cómo funcionan los LLMs de una mejor manera

Echa un vistazo a este video para ver como funcionan los vectores